EL ENTRELAZAMIENTO CUÁNTICO Y EL TIEMPO-ESPACIO...

¿Qué es el tiempo-espacio?

Nueva teoría parece responder la gran pregunta de la física y la filosofía

El entrelazamiento cuántico, con sus extrañas conexiones instantáneas a distancia, parece ser el tejido mismo del tiempo-espacio. Las implicaciones son asombrosas y abrumadoras

Las partículas subatómicas exhiben una propiedad que ha llegado a definir en gran medida la noción popular de que el mundo cuántico es sumamente extraño y misterioso. Se trata del entrelazamiento cuántico o la conexión instantánea entre dos partículas (o sistemas cuánticos) que permite que la medición de una partícula determine el estado de otra no obstante la distancia a la que estén. Así, una partícula en la Tierra puede afectar en este mismo momento a otra partícula que se encuentra en las Pléyades, como si fueran una misma unidad. Esto es algo tan extraño para la física clásica –ya que en apariencia contradice las leyes de la naturaleza, específicamente el límite de la velocidad de la luz– que Einstein lo calificó como una fantasmagórica o espantosa propiedad (“spooky action at a distance“) que debería de ser ficticia. Recientemente, sin embargo, físicos han descubierto que el entrelazamiento cuántico no sólo es real sino que podría ser responsable de la geometría del tiempo-espacio. Paradójicamente fue Einstein quien tuvo la visión de concebir el tiempo-espacio como un continuum esencialmente geométrico.

Una de las grandes innovaciones de Einstein fue su conclusión de que la gravedad es una propiedad de la geometría del tiempo-espacio. En la teoría de Einstein, la interacción entre la materia y la energía y el tiempo-espacio forma una distorsión de la geometría fundamental del tiempo-espacio, esto es la famosa curvatura que tanta especulación ha generado sobre posibles viajes de un extremo a otro del universo. Es a esta distorsión a lo que nos referimos cuando hablamos de la gravedad, una propiedad emergente y relativa. Es decir, la gravedad es geometría, siendo ésta última el constituyente fundamental de la cosmología de Einstein.

El gran reto de la física contemporánea es la conciliación de la gravedad con la mecánica cuántica. Uno de los físicos jóvenes que más se han acercado a finalmente encontrar el hilo dorado de la conexión entre estos dos modelos es Mark Van Raamsdonk, quien ha elaborado una teoría bastante plausible que sugiere que el entrelazamiento cuántico es la base de la geometría del universo y por lo tanto de la gravedad. “El espacio-tiempo es sólo una imagen geométrica de cómo un sistema cuántico se entrelaza”, dice Van Raamsdonk

.

EL PRINCIPIO HOLOGRÁFICO

Van Raamsdonk ha elaborado sobre el principio holográfico del físico argentino Juan Maldacena, el cual sostiene que el universo 3D en el que creemos vivir es el desdoblamiento de un universo en 2D que contiene codificada la información que se despliega como la realidad que experimentamos, de la misma forma que una película holográfica en 2D despliega una imagen en 3D. La teoría, que se conoce también como dualidad de Maldacena, propone que existen dos modelos diferentes del universo. Uno conocido como frontera (“boundary”) el cual se concibe como una superficie en 2D, se define matemáticamente, está libre de gravedad y a una distancia infinita de cualquier punto del otro universo. Este otro universo es conocido como bulto (“bulk”), tiene tres dimensiones y está delimitado por el primero de la misma forma que el aire tridimensional esta encerrado por la superficie bidimensional de un globo. Según explica el editor de la revista Nature, las partículas de este universo voluminoso obedecen a las ecuaciones de los sistemas cuánticos del universo frontera.

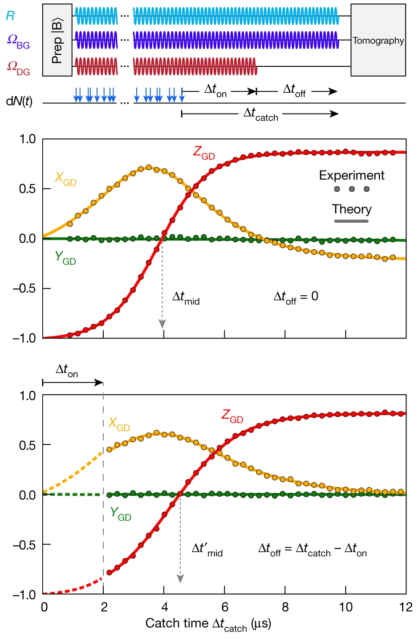

La imagen describe cómo el entrelazamiento cuántico crea el tiempo-espacio. (Olena Shmahalo/Quanta Magazine)

La imagen describe cómo el entrelazamiento cuántico crea el tiempo-espacio. (Olena Shmahalo/Quanta Magazine)

Maldacena hizo que se popularizara la idea de que el universo podría ser un holograma luego de que descubrió que estos dos universos son completamente correspondientes; de la misma manera que el circuito de un chip codifica en 2D las imágenes en 3D de un juego de computadora, la información del universo frontera contiene la información exacta y los principios físicos que rigen el universo bulto en 3D. De tal manera que se ha especulado que nuestro universo podría ser una especie de proyección holográfica que se genera en la superficie de un agujero negro.

EL PEGAMENTO GEOMÉTRICO DEL COSMOS

En lo que se considera un avance posiblemente revolucionario, Van Raamsdonk pudo remover el entrelazamiento que unía a estos dos universos modelo usando una herramienta matemática. El físico observó que cuando se quita este pegamento cósmico en este modelo el tiempo-espacio se empieza a alargar hasta que se fragmenta en pedazos inconexos, “como cuando se estira un chicle demasiado”, todo queda atomizado. Ahora bien, esto es un problema porque la definición misma de tiempo-espacio es la de una unidad continua. Podríamos definir el tiempo-espacio como “la unión de todos los eventos de la misma forma que una línea es la unión de todos los puntos”. En otras palabras, sin el entrelazamiento cuántico el universo simplemente no es un universo. “El entrelazamiento es el ingrediente esencial que teje íntimamente el tiempo-espacio en un todo –y no sólo en el caso de los agujeros negros, sino siempre”, señala Ron Cowen en Nature. “El entrelazamiento es el tejido del universo”, dice Brian Swingle de la Universidad de Stanford, “es el hilo que une todos los sistemas en uno”.

El físico John Preskill explica que el entrelazamiento es lo que permite que “podamos aprender algo de una parte observando otra”, hablando en términos físicos de una especie de sistema de correspondencias o analogías en el corazón de la materia. Juan Maldacena piensa que el entrelazamiento cuántico es responsable de la “bella continuidad del espacio-tiempo. En otras palabras, la estructura sólida y confiable del tiempo-espacio se debe a las propiedades fantasmagóricas del entrelazamiento”.

Engtanglement gravity graphic FINALRGB2_Web

El trabajo de Van Raamsdonk, sumado al de Maldacena y otros físicos, parece haber encontrado el ”pegamento geométrico” del cosmos, del cual es posible derivar un modelo del entrelazamiento cuántico en el que no se ponga en entredicho la ley que impide que algo viaje más rápido que la velocidad de la luz. Las partículas conectadas por el entrelazamiento, se sugiere, forman un agujero de gusano, una especie de túnel que las conecta a la distancia. El entrelazamiento y el agujero de gusano (wormhole), explica Maldacena, son sinónimos. Pero este agujero de gusano no es precisamente un túnel como lo imaginamos normalmente sino que se trata de una especie de atajo o pasadizo que conecta inmediatamente dos puntos en el universo. Según Maldacena el entrelazamiento cuántico genera una “conexión geométrica” que conecta las partículas pese a que “no existe interacción directa entre los dos sistemas”. Los agujeros de gusano son entonces definidos geométricamente y no topológicamente.

En otras palabras, los agujeros de gusano serían en sí mismos información cuántica entrelazada, y no una estructura espacial como tal. El entrelazamiento cuántico parece obligar a que el universo sea no local, los objetos no separables y las diferentes regiones del espacio no independientes. El entrelazamiento cuántico, si tal cosa es concebible, va más allá del tiempo-espacio; es, según Van Raamsdonk, lo que lo crea.

Para entender esto nos puede ayudar la forma en la que Maldacena explica la interacción entre partículas adentro y afuera de un agujero negro. La física mantiene que la información no se destruye, lo cual es un problema en el caso de los agujeros negros, de los cuales, según el modelo viejo, nada puede escapar. Para que la información no se pierda, Maldacena dice que las partículas dentro del agujero negro deben de estar conectadas con las partículas que lo dejaron tiempo atrás (emitidas por la llamada nube de Hawking): las partículas adentro y las partículas afueran son consideradas como la misma partícula. Un complejo agujero de gusano en forma de pulpo vincularía las partículas. Esta es la paradoja central: existe un vínculo y sin embargo las partículas para toda consideración práctica son una y la misma. Esta es la zona prototípica de la llamada quantum weirdness, en la que nos encontramos con una especie de koan cósmico que desafía la lógica ordinaria.

COMPUTACIÓN CUÁNTICA HOLOGRÁFICA

Bajo esta lógica no aristotélica, consideremos el caso de las computadoras cuánticas que teóricamente podrían procesar una cantidad infinitamente superior de información de la que actualmente procesan nuestras computadoras más avanzadas. Las computadoras cuánticas funcionarían a través del entrelazamiento, computando en estado de superposición, simultáneamente ceros y unos, no en bits sino en q-bits. Los q-bits, como pixeles holográficos, estarían almacenados de manera no local, no en un punto específico sino distribuidos en una región amplia del espacio. Van Raamsdonk equipara nuestro universo con una computadora cuántica: “Un chip metafórico almacenando toda la programación del universo debe almacenar la información como una computadora cuántica”. En su modelo los q-bits deben de estar conectados a través del entrelazamiento cuántico de una manera todo-abarcante. “Para tener el tiempo-espacio clásico debes entrelazar todas las partes de tu chip de memoria”, señala Van Raamsdonk. Emerge entonces que el espacio es el trenzado de todos los microestados cuánticos –y este trenzar, esta madeja holográfica es la geometría misma del cosmos de la cual emergen propiedades como la gravedad.

Sin esconder su entusiasmo, Mark Van Raamsdonk externa su epifanía: “Creí entender entonces qué es el tiempo-espacio”. La gran aportación de Einstein fue demostrar que el espacio y el tiempo eran una unidad fluida, un continuum, que tenían una inextricable relación. La física actual parece llegar a un nivel aún más profundo en esa relatividad tiempo-espacial, mostrando que el entrelazamiento es un concepto aún más profundo y esencial que el tiempo y el espacio mismo. Van Raamsdonk sugiere que el universo es esencialmente entrelazamiento cuántico, pero, ¿cómo podemos entender este entrelazamiento cuántico en un sentido filosófico, ya que indudablemente estamos cruzando al terreno de la filosofía?

LA FILOSOFÍA DEL TIEMPO-ESPACIO

Evidentemente creer tener una respuesta concluyente a esto sería demasiado pretencioso. Sin embargo, podemos hacer nuevas preguntas y considerar la cuestión desde distintos ángulos. Para esto, primero revisemos brevemente lo que conocemos sobre el entrelazamiento cuántico. Sabemos que dos partículas están entrelazadas cuando, al realizar la medición de una partícula, la otra partícula instantáneamente será localizada donde los principios de la conservación de energía, momentum, movimiento angular y spin determinan que esté. Antes de esto no podemos determinar su localización (es no local), y es sólo después de la medición que podemos decir que las partículas están separadas. Es por esto que cuando se habla de no localidad se asume también una inseparabilidad.

Según los físicos Nicolas Gisin y Antoine Suarez, esto significa que “algo está viniendo de fuera del tiempo y el espacio”. Marvin Chester escribe en su libro Primer of Quantum Mechanics: “Antes de la medición no hay par de partículas; sólo existe un átomo gigantesco. Este átomo permea todo el espacio. El experimento desmaterializa el átomo, y en su lugar dos partículas aparecen. Cada uno se materializa, como deben de hacerlo en el universo, para preservar las leyes de la naturaleza”.

Esto parece decirnos que el universo en su estado de inconmensurabilidad es un solo átomo, indivisible como la mónada pitagórica. (¿Cómo explicar el entrelazamiento cuántico si no es través de la unidad, más allá de la apariencia de separación?). Es en el acto de medición en el que se separa y se revela como una multiplicidad sujeta al tiempo y al espacio. Existe un factor en la ecuación que quizás Maldacena y Van Raamsdoonk no han considerado: la conciencia. La conciencia sigue siendo uno de los misterios de la ciencia moderna, pero algunos físicos teorizan que podría ser una propiedad tan fundamental como el tiempo-espacio y no una condición emergente. Según Roger Penrose y Stuart Hameroff, la conciencia es algo más que sólo computación, es un “proceso cuántico intrínseco al universo” que está conectado a la estructura del universo en su escala más básica: la geometría del tiempo-espacio. Así llegamos a una extraña red de identidad analógica: tiempo-espacio, geometría, entrelazamiento cuántico y conciencia, ¿acaso distintos términos para describir una misma (y única) cosa? El mismo Hameroff reconoce que esto tiene implicaciones espirituales.

El cabalista Aryeh Kaplan, en su traducción del Sefer Yetzirah, habla de que la visión cabalista concibe el universo como una tríada: tiempo-espacio-espíritu, un continuum (donde podríamos intercambiar conciencia y espíritu). Los textos cabalistas indican que todas las cosas son una sola: la emanación del Ein Sof, la unidad absoluta e incomensurable, lo infinito, el no lugar donde las leyes de la física se anulan y sugieren que solamente percibimos las cosas separadas, distantes entre sí y fragmentarias por un hábito erróneo de percepción –es nuestra cognición, nuestra medición la que separa las cosas y las representa como sujetos y objetos, como diferentes partículas. En el estado no verbal, de la no medición, la realidad, el cosmos entero es una sola cosa –es sólo cuando lo describimos que se multiplica. El físico David Bohm habla de una totalidad implicada de la cual emergen las partículas y los fenómenos que observamos dualísticamente; la totalidad implicada de Bohm, a la cual se refiere como un mar de conciencia y de infinita potencialidad, parece ser algo similar al Ein Sof y al mismo sunyata del budismo, la nada radiante.

Alain Daniélou, el musicólogo francés y erudito del jainismo, explica que en la cosmovisión de los Puranas (los textos sagrados del jainismo) existe una trinidad fundamental: la conciencia, el espacio y el tiempo. Tres aspectos de una única realidad. No difiere del brahmanismo, que considera que la creación es un único pensamiento que ocurre dentro de la conciencia de un ser universal.

Esta trinidad de interdependencia conciencia-tiempo-espacio también fue advertida por Jung. En su libro sobre la sincronicidad, el psicólogo suizo escribe:

Los experimentos Rhine han demostrado que en relación a la psique el tiempo y el espacio son, por así decirlo, “elásticos” y pueden aparentemente reducirse al punto de la desaparición, como si fueran dependientes de condiciones psíquicas y no existieran por sí mismos sino que fueran “postulados” por la mente consciente. En la visión original del mundo, como la encontramos entre hombres primitivos, el tiempo y el espacio tienen una existencia precaria. Se convierten en conceptos “fijos” sólo en el curso del desarrollo mental, gracias sobre todo a la introducción de la medición. En sí mismos, el espacio y el tiempo consisten en nada. Son conceptos hipostasiados engendrados de la actividad discriminatoria de la mente consciente, y forman coordenadas indispensables para describir el comportamiento de los cuerpos en movimiento. Son, entonces, esencialmente psíquicos de origen.

El último aspecto con el que quiero “entrelazar” a la física con la filosofía (siguiendo la vieja idea de que la metafísica de hoy (o ayer) es la física de mañana) es esta idea de la interdependencia. Si el entrelazamiento cuántico permea en su aspecto más básico el espacio, de tal forma que éste puede concebirse como un tejido cuántico de partículas entrelazadas (una vez que una partícula entra en contacto con otra forman un sistema y permanecen entrelazadas teóricamente para siempre) y de regiones espaciales que no pueden considerarse independientemente (y siguiendo la sincronicidad de Jung, también de momentos de tiempo entrelazados), entonces podemos decir que todas las cosas están intrínsecamente conectadas y que dependen unas de otras. Esto es casi exactamente lo que viene diciendo desde hace cerca de 2 mil años el budismo mahayana. De la misma forma en que para la física moderna el entrelazamiento cuántico es equivalente al tiempo-espacio, para el gran filósofo budista Nagarjuna, la interdependencia de todos los fenómenos y todas las cosas es equivalente al vacío. Las cosas están vacías, porque carecen de una existencia inherente e independiente, no tienen una naturaleza propia, individual o separada, están embebidas en el tejido mismo del universo, de la misma forma que una ola no tiene una existencia independiente del océano (¿y una partícula de la espuma cuántica?). Jay Garfield, traductor del Mulamadhyamakakarika, el texto esencial de Nagarjuna, pone el ejemplo de una mesa (y por qué está vacía):

Su existencia como objeto, eso es, como mesa, no sólo depende sí misma o de cualquier característica no relacional, sino también en nosotros. Eso es, si este tipo de mueble no hubiera evolucionado en nuestra cultura, lo que nos parece ser un objeto obviamente unitario en cambio sería descrito correctamente como cinco objetos: cuatros palos bastante útiles absurdamente montados sobre una tabla de madera esperando a ser labrada. Esto es para decir también que la mesa depende para existir de sus partes, de sus causas, de su material, y así sucesivamente. Aparte de éstos, no hay mesa. La mesa, podemos decir, es una tira de tiempo-espacio puramente arbitraria elegida por nosotros como el referente de un nombre único, y no una entidad demandando, por su propia cuenta, reconocimiento y análisis filosófico para revelar su esencia.

Como la mesa, dice Nagarjuna, todos los fenómenos están vacíos y no tienen existencia real independiente. Incluyendo el vacío mismo. Y quizás no se equivocaba el gran maestro budista, puesto que al parecer el tiempo-espacio es en el nivel más básico que podemos conocer una serie de partes vinculadas a otras partes y así hasta el infinito. Todas las cosas, nosotros mismos, estamos hechos de este entrelazamiento, de esta concatenación, de esta pratītyasamutpāda (originación dependiente), de esta cadena de reflejos insustanciales que emergen y regresan siempre al vacío y que por lo tanto no se puede decir que tienen una esencia diferente a ese vacío.

Las implicaciones son realmente abrumadoras.