Ponencia:

Bienvenidos a esta ponencia llamada “¿Qué demonios pasa últimamente con los agujeros negros?”. El hecho de que se llame así se debe a una serie de noticias que han ido saliendo a lo largo del último año con respecto a los mismos en diversos medios. En ellas se comenta que Stephen Hawking ha dicho que no existen, que son imposibles matemáticamente y toda una serie de afirmaciones que entiendo que para quienes no estén muy metidos en el tema pueden resultar chocantes como poco.

Así pues, mi objetivo es conseguir arrojar luz al asunto y argumentar cómo es posible que la persona que todo el mundo asocia con los agujeros negros debido a su libro “Historia del tiempo” ahora se oponga radicalmente a ellos. En suma, intentaré contestar a la pregunta sugerida de si Stephen Hawking es o no es un troll y que quede más o menos claro que no, porque en las últimas décadas se han hecho descubrimientos teóricos que hacen razonable que cambiase de postura.

Pero antes de hablar sobre qué sucede con los agujeros negros es necesario comentar qué es un agujero negro. La definición habitual en divulgación es que es un tipo de estrella con una gravedad tan elevada que ni siquiera la luz puede escapar de ella. Por otra parte, en la definición ligeramente más pedante que solemos usar en física es que un agujero negro es una región del espacio en la que cualquier partícula que entre queda inmediatamente desconectada causalmente del universo exterior, estando obligada siempre a permanecer en su interior.

Esta definición es teleológica, en el sentido de que un agujero negro definido de esta forma depende del futuro para ser considerado como tal. Solo podemos decir que una región del espacio lo es si nunca sale nada y “nunca” es mucho tiempo. Tanto que no podemos asegurar en ningún momento que tengamos un agujero negro delante solo porque no hayamos visto salir nada de él durante años.

¿Pero cómo puede haber una región del espacio que no permita a absolutamente nada escaparse? La cuestión no es trivial, de modo que dedicaremos el principio de esta ponencia a comentarlo.

Dedicaremos un 13% de las diapositivas a hablar de la historia de la confirmación de la relatividad de Einstein, Después un 33% de ellas servirán como introducción histórica del concepto de agujero negro y, finalmente, dedicaremos la mayor parte de la ponencia, un 54% de diapositivas, al gran conflicto de la física teórica.

Es relativamente conocido que la física teórica lleva décadas en conflicto debido a que sus dos modelos fundamentales, la gravedad y la física cuántica, no parecen encajar adecuadamente el uno con el otro. Los agujeros negros son el principal campo de batalla entre ambas propuestas y son sin duda causantes de todos los avances realizados en el desarrollo de la gravedad cuántica. No trataré ese tema aquí, pero sí que comentaremos su principio más importante.

La teoría de la relatividad es una teoría desarrollada por Einstein entre los años 1905 y 1915 y, si bien es mucho más compleja que lo que he expuesto en esta diapositiva, podemos conformarnos con mencionar tres de sus conclusiones:

- “Los relojes sometidos a mayor energía (dejando ese concepto muy en el aire) son más lentos porque el espacio-tiempo se curva”. Esto viene a decir que en las proximidades de una región donde haya energía los relojes avanzarán más despacio que en otra vacía. En la teoría de Einstein, además, la masa es energía, con lo que prácticamente todo curva el espacio-tiempo.

- “La curvatura localmente no es percibida por quien la sufre”. Esto se conoce como el principio de equivalencia y es un pilar de la teoría, como veremos al tratar con agujeros negros. Aunque nuestros relojes sean más lentos al estar sometidos a energía, para nosotros sería imposible percibirlo dado que nuestro ritmo cardíaco, nuestra respiración y demás también lo serían. Sería necesario que alguien nos observase desde fuera para poder confirmar que el tiempo nos transcurre más despacio al comparar.

- “La velocidad de la luz en el vacío es la máxima observable”. Poco que comentar aquí para lo que nos ocupa.

El principio de equivalencia fue planteado en base a este ejemplo donde tenemos la Tierra de color azul, su centro representado por un punto y, sobre ella, un gran ascensor con tres bolas en su interior. El motivo por el que elegimos un ascensor es simplemente que era lo novedoso a principios del siglo XX, cuando Einstein planteó el problema (otro muy parecido, en realidad).

Si una persona en el ascensor suelta las tres bolas verá que prácticamente caen en paralelo. Sin embargo, si alguien ve las bolas caer desde la Tierra durante un tiempo muy prolongado, opinará que claramente su movimiento no es paralelo, dirigiéndose todas ellas al centro del planeta y aproximándose mientras tanto.

El principio de equivalencia nos dice, en suma, que para poder apreciar curvatura es necesario observar a grandes distancias o durante tiempos muy grandes las distintas trayectorias sometidas a esta. Del mismo modo que el ascensor sería muy pequeño para apreciar en él que las bolas se acercan y no caen en paralelo, para alguien con un reloj de tiempo dilatado es imposible percibir tal dilatación.

Estos efectos fueron probados con precisión entre 1916 y 1919, poco después de que Einstein publicase su teoría, debido a dos fenómenos astronómicos relativamente sencillos que la podían ponerla prueba.

En 1916 Karl Schwarzschild publicó su solución para problemas relativistas donde la energía esté concentrada en una esfera. Dicha solución resolvió inmediatamente el problema de la precisión de la órbita de Mercurio.

Mercurio sabe, porque así se lo dijo Newton con su ley de gravitación universal hace 300 años, que dada su distancia al Sol, cada cierto tiempo tiene que dar una vuelta con forma de órbita elíptica. Pero Mercurio tiene un problema. Como su distancia al Sol no es la misma durante todo su recorrido, su tiempo tampoco lo es. Así, cuando está más cerca de nuestra estrella su reloj es más lento y cuando está más lejos es más rápido. Pero debido al principio de equivalencia, Mercurio no percibe esto. Así pues, cuando completa una vuelta de 360º, como para él ha pasado menos tiempo que para un observador externo, piensa que todavía no tiene que acabar y vuelve a empezar desfasado. Concretamente, Mercurio se desvía por este efecto 43” de arco de su órbita cada siglo, y desde mediados del siglo XIX hasta la llegada de la relatividad era un fenómeno sin explicación.

En 1919, además, la relatividad fue puesta a prueba al comparar la posición de estrellas en dos situaciones diferentes. Cuando observamos una estrella en frente nuestra, recibimos su luz en línea recta e identificamos su posición en el cielo correctamente. Sin embargo, Eddington verificó que si esa misma estrella estuviese detrás del Sol, su luz podría llegarnos curvada y parecer estar en otra posición incorrecta. La deflexión gravitatoria de los rayos de luz era un fenómeno no considerado por la teoría de Newton.

Más adelante, en 1959, se verificó el efecto Doppler relativista completo con el experimento Pound-Rebka.

El efecto Doppler clásico habla de cómo afecta a la frecuencia percibida de una onda la velocidad de su foco (y de su receptor). Si tenemos un coche con una sirena sonando, los observadores (oyentes) frente a este percibirán una frecuencia más elevada debido a que, al aproximárseles la fuente, cada señal surge desde más cerca que la anterior. Por el contrario, los observadores que escuchen alejarse al coche medirán una frecuencia menor. Esto se conoce como efecto Doppler cinético: cambios en la velocidad involucran cambios en la frecuencia.

Pensemos ahora que tenemos dos átomos iguales con dos niveles energéticos para sus electrones. Cuando un electrón pasa del nivel 2 al nivel 1 emite un fotón con la energía exacta que hay entre esos niveles. Este fotón puede ser absorbido por el otro átomo para ascender desde el nivel 1 hasta el nivel 2.

En el experimento Pound-Rebka, los átomos eran ubicados a diferentes alturas sobre la Tierra, y el de abajo emitía su fotón hacia el de arriba. Sin embargo, el de arriba era incapaz de percibirlo. ¿Por qué? Porque el tiempo depende de la distancia a la superficie de la Tierra, y al ser el tiempo más rápido a mayor altura, la frecuencia se reduce. Así, tenemos un efecto Doppler gravitatorio que ha reducido la energía del fotón durante su ascenso, al estar esta relacionada con la frecuencia.

Para verificar que la dilatación temporal era acorde con la relatividad, en el experimento movieron hacia arriba el átomo de abajo con distintas velocidades de forma que el efecto Doppler cinético compensase al gravitatorio, comprobando que la combinación de ambos era acorde a la teoría.

¿Cuando surgieron los problemas? Cuando hubo que interpretar la solución de Schwarzschild a pequeñas distancias de la energía.

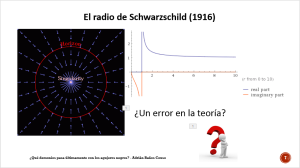

Si bien todo funcionaba correctamente a distancias grandes, el modelo de Schwarzschild involucraba una distancia conocida como radio de Schwarzschild (Schwarz) sobre la cual la dilatación gravitatoria del tiempo se hacía infinita. Esto implicaba que un segundo a dicha distancia de una cierta cantidad de energía era equivalente a infinitos segundos en el exterior. La gráfica de la derecha, sin unidades, pretende ilustrar el cociente entre el tiempo externo y el interno según la distancia.

El radio de Schwarz aparece en la distancia en la que la teoría de Newton predice una velocidad de escape mayor que la de la luz en el vacío. Supongamos un cuerpo quieto y pongamos a su lado una masa mucho mayor concentrada en un punto. Cuanto más cerca esté el cuerpo de la masa, con más velocidad estaría cayendo hacia ella, llegando según Newton a alcanzar velocidades infinitas a distancias ínfimas. Para evitar por axioma que algo se mueva más rápido que la luz en el vacío, en la relatividad esa distancia deforma el espacio-tiempo creando un horizonte de sucesos.

Esto resultaba muy desagradable para los físicos, y en particular para Einstein, dado que involucraba una región del espacio que, por ejemplo, podría ver el final del universo tan tranquila. Desde el exterior llevaría un tiempo infinito ver algo llegar hasta el horizonte, pero para ese algo no. Así, cuando ese algo atravesase el horizonte resultaría que el universo que dejaría atrás ya habría terminado. Habría transcurrido un tiempo infinito fuera.

Como consideración provisional, en los veinte se asumió que tal horizonte era un error de la teoría absurdo y que no debía tomársela en serio a tan cortas distancias. El radio de Schwarz de la Tierra es de 1 cm. El del Sol es de 3 km. Para que cualquiera de ellas generase un horizonte debían de comprimirse por debajo de esos límites.

Sin embargo, el horizonte de sucesos era muy persistente en relatividad, dado que salía en muchas otras soluciones, como la de Reissner-Nordström para un agujero negro cargado.

En ese caso no solo había un horizonte sino dos. El exterior y el interior, anulando cada uno los efectos del otro. Cuando un cuerpo caía al agujero cargado y atravesaba el horizonte interno volvería a encontrarse en un espacio normal y corriente. Si consiguiese volver a salir fuera atravesando el horizonte interior y después el exterior tal vez apareciese en un universo nuevo, dado que el anterior ya habría terminado desde el momento en que atravesó el horizonte por primera vez.

Sin embargo, esta máquina para viajar entre distintos universos fue descartada al estar todo lo que atraviesa el horizonte condenado a terminar en la singularidad central.

… O al menos así era hasta que Kerr presentó su solución rotatoria en 1962. En estas circunstancias, se mantenían los dos horizontes, pero la singularidad central se convertía en un anillo atravesable sin problemas por el centro.

Además, alrededor del agujero se producía una ergosfera en la que el propio espacio podría rotar a gran velocidad. Sobre dicha ergosfera la materia se acumularía formando un disco de acreción y, al llegar a los ejes del agujero, esta saldría despedida con gran energía. Esta solución describe, entre otros, los púlsares, las mayores fuentes de radiación conocida. Michio Kaku planteó en su libro “Hiperespacio” que tal vez una civilización más avanzada los usaría como armamento.

Durante los años veinte comenzaba a desarrollarse la astrofísica nuclear, basada en las reacciones de fusión. Las estrellas típicamente estarían constituidas en sus fases iniciales de hidrógeno, cuyo núcleo es un protón. Cuando un átomo de hidrógeno absorbe un neutrón forma deuterio, y si absorbe dos forma tritio.

El deuterio y el tritio separados tienen una cierta energía, pero la naturaleza es vaga y sabe que si los funde en helio tienen menos energía, de modo que intenta fusionarlos. De este modo, las estrellas juntan los núcleos haciéndoles ocupar menos y liberando la energía sobrante como la radiación que percibimos.

Ahora bien, una estrella no siempre dispone de energía suficiente para fusionar núcleos superando la montañita de energía de la gráfica. Cuando eso sucede puede forzarles a juntarse mediante el principio de incertidumbre, otorgándoles energía extra durante un tiempo no medible. Esta violación instantánea del teorema de conservación de la energía se conoce como efecto túnel, y es tanto más probable que se de cuanta más presión y temperatura haya en la estrella. Vulgarmente, diremos que las partículas que atraviesan una barrera energética así “tunelean”.

Como las reacciones de fusión no son inmediatas como lo es la gravedad, una estrella no se comprime por completo en un instante, sino que tiene que esperar hasta conseguir ir fundiendo núcleos con “suerte”.

¿Y qué pasa cuando se acaba de fundir? Pues en los veinte se entendía que una vez alcanzada la máxima compresión como átomos de hierro el principio de exclusión entre partículas daría estabilidad a una estrella inerte. Dichas estrellas, observadas, fueron denominadas enanas blancas, y si siguen emitiendo luz es porque siempre, estadísticamente, les quedarán algunos últimos suspiros de vida. El principio de exclusión es lo que su nombre indica: dos átomos iguales no pueden ocupar el mismo lugar, de modo que la compresión tiene un límite para apretarlos.

En los años treinta el astrofísico Zwicky planteó que las enanas blancas no tendrían por qué ser las estrellas muertas definitivas, y que dado que el núcleo atómico es 10000 veces más pequeño que su corteza tal vez algunas hubiesen conseguido constar exclusivamente de núcleos. Como decíamos, la naturaleza es vaga, extremadamente vaga, y si le es posible ahorrar energía siempre lo hará a cualquier coste. Así, eventualmente una estrella podría ser capaz de juntas los electrones de la corteza de sus átomos con los protones de sus núcleos para formar neutrones mucho más compactos emitiendo diversos neutrinos durante el proceso. El resultado sería una estrella de neutrones. En principio no habría nada más compacto que dicha estructura.

Tanto la enana blanca como la estrella de neutrones descansan sobre las bases de la estabilidad cuántica del principio de exclusión, pero este no tardó mucho en ser puesto a prueba.

En 1931, el físico indio Chandrasekhar calculó que una enana blanca con una masa del 150% de la solar estaría condenada a colapsar gravitatoriamente, planteando que así surgirían los agujeros negros. La propuesta de Zwicky de una estrella de neutrones, sin embargo, puso a salvo de nuevo a la física de tales objetos. Pero solo hasta 1958, cuando un estudio más detallado del problema llevó a concluir que una estrella de neutrones con el 200% de la masa del Sol colapsaría también.

Así pues, el ciclo astrofísico del universo sería algo así: todo estaría típicamente lleno de átomos dispersos formando nébulas. Dentro de estas nébulas, algunos se juntarían gravitatoriamente formando estrellas. Si la masa de las estrellas fuese pequeña, estas se irían fundiendo, creciendo “momentáneamente” al final de sus vidas para formar gigantes rojas que, tras explotar, darían lugar a una enana blanca de masa entre el 0% y el 150% de la del Sol. Por otra parte, estrellas más grandes formarían supergigantes rojas y explotarían en supernovas dando lugar a estrellas de neutrones si tuviesen hasta el 200% de la masa del Sol y, con más masa, a agujeros negros.

Toda la materia liberada por supernovas y demás explosiones volvería a formar nébulas.

El estudio de la evolución estelar se llevó a cabo en los cincuenta en Estados Unidos a cargo del físico John Wheeler, precursor del estudio de los agujeros negros. La mayoría de sus estudiantes realizaron las contribuciones más importantes al estudio de los mismos, si bien refiriéndose a ellos inicialmente como estrellas congeladas.

Este nombre era debido a sus propiedades dinámicas. Como mencionamos, ver a algo llegar hasta un horizonte lleva un tiempo infinito, de modo que el colapso hasta un agujero negro nunca se podría observar completamente. Solo “casi” completamente. La única forma de ver la formación completa sería aproximarse y colapsar con la estrella.

En 1967 Wheeler planteó buscar otro nombre que llamase más la atención y así surgió el término agujero negro. A nivel de márketing era muy adecuado, dado que era trasgresor y llamativo. Tanto que en Francia y Rusia causó recelo. Pero Wheeler consiguió su objetivo: captar la atención de más gente.

Otros éxitos bautismales de Wheeler fueron el término agujero de gusano, que mencionaremos hacia el final, y el de que los agujeros negros no tienen pelo, en alusión a la carencia de rugosidades sobre su superficie.

Con respecto a la pregunta sobre si podría formarse en el espacio alguna singularidad visible, en 1969 el matemático Roger Penrose contestó que “seguramente no” con su conjetura de censura cósmica. Una singularidad es una región de espacio desnudo y el universo es un censor que no quiere que lo veamos en esas circunstancias, o al menos es lo que él consideró que parecían sugerir las matemáticas. Así, toda singularidad debería estar siempre vestida con un horizonte de sucesos.

A Penrose se le deben, además, los diagramas espacio-temporales para representar agujeros negros, sobre los que no entraré en detalle.

La fiesta empezó en los setenta, cuando uno de los chicos de Wheeler, Jacob Bekenstein, comenzó a pensar sobre la relación entre los agujeros negros y la termodinámica.

La termodinámica tiene cuatro postulados inquebrantables que dicen que todo sistema aislado tiene temperatura, conserva su energía, nunca disminuye su entropía o desorden y en ningún caso consigue suprimir su temperatura. Murphy, el de la ley de Murphy, los reformuló de forma pesimista como “No puedes ganar (contra la energía)”, “No puedes empatar (contra la entropía)” y “No puedes abandonar (contra la temperatura)”.

La entropía es una medida de los posibles estados de un sistema según nuestro conocimiento sobre él. Así, un gas ocupando mucho volumen tiene mucha más entropía que uno ocupando poco porque sus moléculas pueden distribuirse de muchas más formas.

Bekenstein consideró la posibilidad de lanzar gas con entropía a un agujero negro. ¿Se disminuiría esta en el universo? Lo lógico para él era pensar que no, de modo que postuló que los agujeros negros deberían poseer entropía y se puso calcularla cualitativamente.

Su conclusión fue que el incremento de entropía era proporcional al área del horizonte del agujero, y que la cantidad mínima de entropía en la que podía aumentar este tenía que ser un múltiplo de un área diminuta conocida como área de Planck. De este modo, podría teselarse la superficie del horizonte con áreas de Planck y asignar a cada una un pedacito de entropía.

Y si el agujero negro tenía entropía y energía (debida a su masa) también tendría que tener temperatura. Surgieron así las tres leyes provisionales (actualmente falsas) de la termodinámica de agujeros negros: todo agujero negro tiene gravedad, conserva la masa, nunca disminuye su área y no puede alcanzar la gravedad nula.

Llegados a este punto es importante hacer un inciso para comentar las unidades de Planck. En 1899 Planck se dio cuenta de que existían 5 constantes fundamentales asociadas a cinco teorías diferentes: la constante de gravitación universal asociada a la gravedad, la permitividad del vacío asociada a la electrostática, la velocidad de la luz en el vacío asociada a la relatividad (por aquel entonces solo a punto de nacer), la constante de Planck asociada a la cuántica (lo mismo que la anterior) y la constante de Boltzmann asociada a la termodinámica. Mirando cuáles de estas constantes aparecen en una ecuación es posible identificar la teoría a la que pertenece.

En el caso de la entropía “S” de Bekenstein aparecían cuatro de las cinco constantes multiplicando al área. La que faltaba, la permitividad, podía aparecer si el agujero negro estuviese cargado. De modo que su fórmula fue, históricamente, el primer concepto de una teoría a la vez gravitatoria, electrostática, relativista, cuántica y termodinámica.

Las letras BH en la entropía tienen dos significados. Por un lado significan “black hole” (agujero negro en inglés) y por el otro son las iniciales de dos físicos teóricos. El primero de ellos es Bekenstein. El segundo Hawking.

Que Hawking aparezca aquí es una de estas grandes ironías del destino, dado que cuando escuchó la teoría de Bekenstein consideró que era absurda. Si los agujeros tenían temperatura tenían que radiar como todos los demás sistemas térmicos del universo, pero nada podía salir de un agujero negro.

¿O sí? Intentando desmentir la termodinámica de agujeros negros Hawking se dio cuenta de que, dado que el principio de incertidumbre permite al vacío generar energía en minúsculos periodos de tiempo en forma de pares de partículas que aparecen y se aniquilan, tal vez alguno de estos pares que surgiese próximo al horizonte no se podría aniquilar. Si en la frontera de un agujero se crean dos partículas, una cae hacia dentro y otra sale hacia fuera, es imposible que vuelvan a contactar y por tanto que desaparezcan en un tiempo diminuto.

Así pues, Hawking concluyó que debido a los procesos aleatorios del vacío, un agujero negro eventualmente se evaporaría por completo debido a la pérdida aleatoria de masa mediante radiación Hawking. Las partículas podrían “tunelear” hacia fuera del agujero. Cada vez que una partícula fuese radiada, extraería energía del agujero, y este perdería masa y entropía violando la primitiva termodinámica de agujeros negros. La entropía del universo aumentaría porque la radiación sería más entrópica que cuando formaba parte del agujero.

Ahora bien, si el agujero negro radiaba cosas aleatoriamente la información se perdería, lo que iba en contra de las leyes de la mecánica cuántica de Heisenberg. Esto se conoce como laparadoja de la información.

Es frecuente que se piense que la mecánica cuántica supone el fin del determinismo, pero la cuestión no es tan sencilla. La función de onda probabilística de la física cuántica, si bien nos impide calcular la posición y la velocidad de una partícula simultáneamente, evoluciona de un modo 100% determinista. Esto implica que conociendo la función de onda en un instante y su contexto es posible saber tanto su futuro como su pasado inequívocamente.

Para entendernos mejor, podríamos pensar en la mecánica clásica como un libro donde la información siempre es visible y analizable sin duda. La mecánica cuántica sería el equivalente a guardar ese libro en una caja fuerte. Tal vez no podamos acceder a su información, pero sabemos que está ahí. Por último, la propuesta de Hawking sería equivalente a dar por válido que la caja fuerte pudiese desaparecer de repente.

Si un agujero negro además de ocultar información pudiese destruirla al evaporarse la mecánica cuántica estaría en peligro, de modo que contra lo que se podría pensar los teóricos de partículas tuvieron que salir al rescate del determinismo.

Para los “relativistas” no había ningún problema en la pérdida de información porque no era de su incumbencia. La mecánica cuántica podría estar mal porque no era su área de conocimiento. Para los “cuánticos” la radiación aleatoria de Hawking era una declaración de guerra. Una guerra que comenzó en 1981 cuando Leonard Susskind, padre de la teoría de cuerdas, y Gerardus ‘t Hooft, Premio Nobel de Física de 1999, se enteraron de lo que andaba diciendo por ahí Hawking.

Durante más de 15 años desde el comienzo de la guerra la controversia sobre la pérdida de información fue marginal dado que no todos lo consideraban un problema grave o interesante. El propio Feynman declaró en su momento que creía que preocuparse por la gravedad cuántica iba más allá de lo que debían preocuparse en el siglo XX.

Sin embargo, los que le daban importancia llegaron a hacer apuestas sobre el tema, como es el caso de la archiconocida apuesta entre Kip Thorne, Hawking y John Preskill. Los dos primeros apostaron en 1997 contra el segundo que la información se perdía en los agujeros negros. La imagen de la izquierda es de otra apuesta entre estos tres físicos.

Thorne es relativamente conocido por haber asesorado a Carl Sagan en “Contact”, así como a Nolan con “Interstellar”, además de haber sido el precursor del estudio de los agujeros de gusano.

Coincidiendo con el año de la apuesta, Susskind y ‘t Hooft se atrevieron al fin a publicar su solución a la paradoja de la información: el principio holográfico.

La idea surgió más o menos así: supongamos que una civilización avanzada condena a un preso a muerte y deciden lanzarlo a un agujero negro caliente. Como el agujero radia mucho, al arrojarlo desde la nave verán que el preso se incinera cerca del horizonte. Sin embargo, debido al principio de equivalencia el preso no percibirá nada raro durante su caída.

El principio holográfico vendría a decir que el horizonte es un holograma del interior del agujero (o viceversa, según gustos), y que desde fuera ven la representación holográfica del preso siendo incinerado en la singularidad. Realmente moriría en el interior del agujero negro, pero desde fuera solo se vería una representación de ello en las proximidades del horizonte.

Así pues, el horizonte tendría que estar compuesto de información almacenada en cada pedazo de área de Planck del mismo.

Más radical aún, el horizonte debería ser capaz de almacenar tanta información como el interior del agujero, o expresado al revés, el interior del agujero no podría contener más información que la que cupiese codificada en su horizonte. De este modo interior y frontera estarían conectados perfectamente y la información no se perdería en absoluto. La materia que cae a un agujero negro aportaría información y área a su horizonte, y más adelante sería emitida de nuevo como radiación Hawking.

El principio holográfico no tardó nada en tomar el control de los estudios en física teórica, en particular dentro de las teorías de cuerdas, y actualmente es lo que tiene más éxito dentro del mundillo.

Tanto es así que en 2004 Hawking aceptó oficialmente que había perdido su apuesta frente a Preskill y, tal y como habían pactado, le regaló una enciclopedia de béisbol. Thorne, por su parte, no colaboró en el pago porque, hasta donde sé, a día de hoy sigue pensando que no ha perdido.

Cabe destacar que Hawking no reconoció haberse equivocado muy a la ligera, sino que recalcó que la información se conserva, pero tan descolocada que es como si se hubiese perdido, llegando a bromear con que tal vez debería haberle regalado a Preskill una enciclopedia incinerada dado que contendría información con la misma claridad que un agujero negro.

A modo de recopilatorio, años después Susskind escribió “La guerra de agujeros negros”, donde relata como si de la Segunda Guerra Mundial se tratase toda esta disputa.

Pero obviamente este no fue el fin de la historia. Si no no tendríamos estas noticias mencionadas al principio en pleno 2014.

En 2012 se publicó la teoría del muro de fuego, que dice que dado que la radiación Hawking desvincula dos partículas del vacío que inicialmente estaban ligadas esta pérdida deentrelazamiento tiene que implicar una liberación de energía en forma de pequeñas explosiones sobre el horizonte.

Esta teoría contradice gravemente el principio de equivalencia de Einstein, dado que haría el horizonte localmente perceptible.

Otra forma de resolver ese problema es en el que están trabajando actualmente Susskind y Juan Maldacena, autor de la primera aplicación del principio holográfico en teoría de cuerdas.

Su propuesta usa agujeros de gusano, que son soluciones geométricas de la relatividad donde dos regiones del universo alejadas se conectan instantáneamente mediante una dimensión extra normalmente imperceptible.

Según su modelo, las partículas que entran en un agujero negro saldrían como radiación Hawking al exterior mediante agujeros de gusano, de forma que interior y exterior estarían causalmente conectados y se podría mantener el entrelazado.

En todo caso, lo que sí es bastante general es que los agujeros negros seguramente sean descriptibles como un condensado de gravitones o, dicho de otro modo, ondas de gravedad.

Uno de los principales defensores de este modelo es Hawking, quien este año en enero dijo que dicho gas gravitatorio sería lo que hasta ahora llamábamos agujero negro y que el horizonte de sucesos, así como el muro de fuego, debían de ser abandonados.

Personalmente considero esto lo más lógico, dado que así el principio holográfico chocaría menos. Si en la superficie del horizonte nunca vemos nada desaparecer del todo, tal vez sea porque nunca desaparece del todo.

Además, tan recientemente como en septiembre la cosmóloga albanesa Laura Mersini-Houghton ha publicado que mediante simulación por ordenador de una estrella en colapso capaz de emitir radiación Hawking resulta imposible que un agujero negro se forme.

Según comenta, parece que cualquier estrella colapsante se evaporaría completamente antes de llegar a formar un agujero negro, y que consecuentemente la física teórica lleva 50 años estudiando un objeto imposible. Tan imposible como ya supusieron que debía serlo Einstein y Eddington en los veinte.

Esto lleva inmediatamente a las preguntas: ¿es entonces fútil todo el esfuerzo dedicado a este tema? ¿Deberíamos dejar de hablar ya mismo de agujeros negros? Bueno, es complicado. Aunque los agujeros negros finalmente no existiesen, parecen haber abierto un claro camino hacia la gravedad cuántica…

… y a otras formas de estudio del universo.

El principio holográfico combinado con la teoría de cuerdas ha dado lugar a modelos en los que nuestro universo es un holograma tridimensional de un espacio de cuatro dimensiones en el que reside un agujero negro al que envolvemos. Así, la temperatura del universo vendría dada por la del agujero negro tetradimensional y un largo etcétera de conclusiones.

Este modelo tiene la utilidad de que las cuentas en cuatro dimensiones en varias ocasiones resultan más sencillas que en tres, y como están relacionadas holográficamente a veces compensa añadir una dimensión extra para hacer llegar a las mismas conclusiones más rápido.

Como broche final para esta ponencia me gustaría concluir con una frase del físico Lev Landau de los años treinta, que dice así: “Los cosmólogos frecuentemente están equivocados, pero rara vez dudan”.

Muchas gracias.